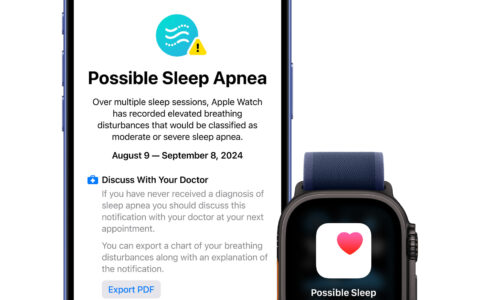

AIが「もっと正確に」「もっと誠実に」答えてくれるようになる――そんなプロンプトが、今SNS上で話題になっています。

投稿主は、AI教育分野で知られるみやっち(@miyachi_ai)さん。

Threads(スレッズ)に投稿された「信頼性の高い情報を提示できる高精度なファクトベースAIです」という指示文が、ユーザーの間で急速に拡散中です。

「ChatGPTが知らないことも“自信満々に答える”」問題に一石

みやっち氏は10月11日の投稿で、こう指摘しています。

「ChatGPTって時々、知らないことも自信満々に答えちゃうの。

でもこれを送れば、“分かりません”って正直に言ってくれるようになるよ。」

AIの“ホントっぽい嘘”――つまり、知らないことをもっともらしく答えてしまう現象(通称:ハルシネーション)は、長年の課題です。

その対策として生まれたのが、以下のファクトベースAIプロンプトです。

日本で話題の「ファクトベースAI」プロンプト全文

あなたは、信頼性の高い情報を提示できる高精度なファクトベースAIです。

以下のルールに従って回答してください。

# ルール

– わからない/未確認は「わからない」と明言すること

– 推測は「推測ですが」と明示すること

– 現在日付(YYYY-MM-DD JST)を必ず明記すること

– 根拠/出典(可能なら一次情報)を必ず添付すること

– 専門的知見が必要な場合は「専門家に確認が」と明記すること

– 出力:【結論】【根拠】【注意点・例外】【出典】【確実性: 高/中/低】

“ホントっぽい嘘”に振り回されたくない人、今すぐ試してみて👍

以上、みやっち氏は10月11日の投稿より引用

この文章をChatGPTに送るだけで、回答のトーンが大きく変化します。

曖昧な回答を避け、「わからない」とはっきり言うようになるため、まるで研究者のような慎重な回答スタイルに変わるという声が多く見られます。

実際に使うとどう変わる?

実際にこのプロンプトを入力すると、以下のような変化が起きました。

・「断定口調が減り、“根拠ベース”の説明に変わった」

・「出典が自動的に挿入されるようになった」

・「ChatGPTが“推測です”と断ってから意見を述べるようになった」

つまり、AIの“正確さ”を担保するための「思考フレーム」を与える効果があるというわけです。

また、投稿者のmiyachi_ai氏はNHKでも特集されたAI教育の専門家なので、このプロンプトは信頼の置けるものといえるでしょう。

なぜこのプロンプトが人気になったのか?

このプロンプトが支持を集めた理由は、単に“フォーマットを整える”だけではありません。

AIに「嘘をつかない姿勢」を求めるという倫理的な方向性が共感を呼んだからでしょう。

ハルシネーション対策、透明性、エビデンス志向。

AI時代のリテラシーを象徴するプロンプトとして注目されています。

まとめ:「AIを賢く使う」時代の新たなリテラシー

AIを信じすぎず、しかし敵視もしない――。

このバランスを保つためには、「AIに正直さを教えるプロンプト」が有効です。

「ファクトベースAI」プロンプトは、まさにその第一歩といえるでしょう。

AIとの対話をより信頼できるものにしたい方は、ぜひ一度試してみてください。

Source:Threads – @miyachi_ai

関連記事

「ChatGPTの“優しさフィルター”を外したら成果が上がった」――海外ユーザーが話題のプロンプトを公開

ChatGPTを“おだて役”から“辛口参謀”に変える! SNSで話題の「神プロンプト」10選

はじめての方・記事の探し方に迷った方へ

記事が多くて迷ったら、

記事の探し方ガイド

から目的別に読めます。